“嬛嬛,朕emo啦!”

此前,一位名为“奶茶小肥仔”的博主靠模仿陈建斌的声线唱歌走红,“朕emo啦”“朕能不能睡中间”等网络热梗广为流传。新榜旗下数据工具新抖显示,“奶茶小肥仔”在抖音半年粉丝量飙升370万。

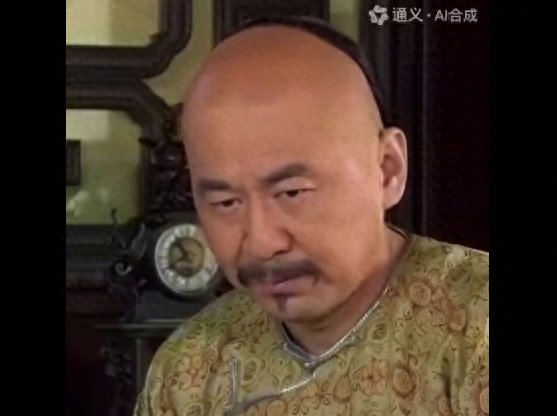

在他的视频中,网友往往只能看到《甄嬛传》的素材剪辑,如今,一款EMO模型的出现,让网友直接看到了“皇上开口唱歌”这一毫无违和感的画面。

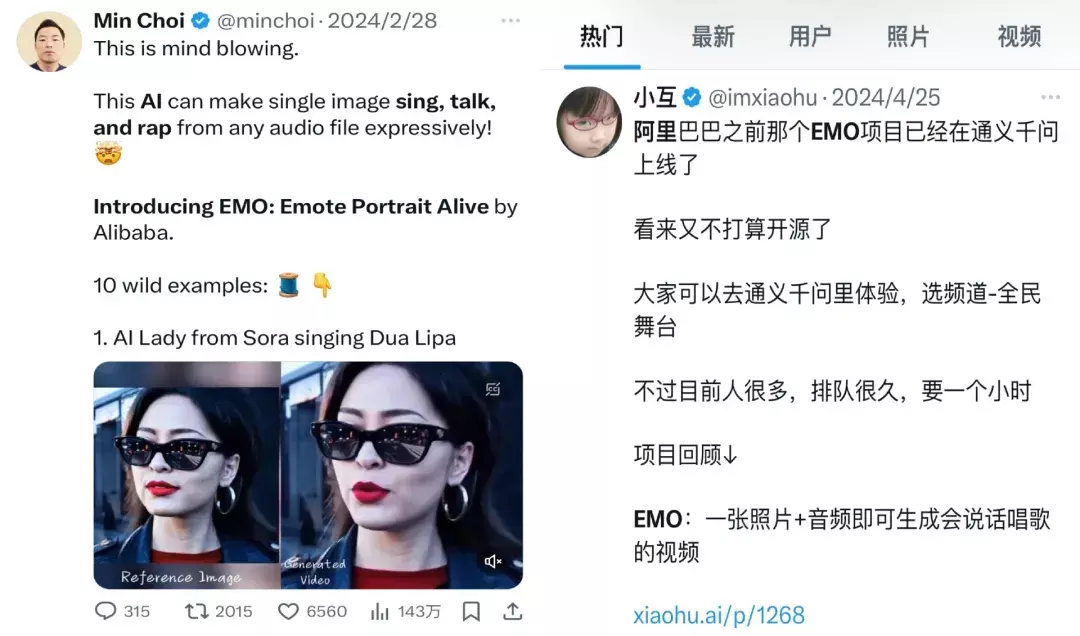

近期,阿里通义实验室研发的AI视频生成模型“EMO”上线通义APP“全民舞台”频道,经测试,只需上传一张大头照,就可以让人物照片动起来,根据App预置的音频模板生成演唱视频。

阿里EMO模型于今年2月公开技术论文,产品化仅用了两个多月的时间。

从官方演示被一众科技圈KOL轮番转发、引爆话题度,到4月25日正式上线通义App,传出服务器一度被挤爆。

这款被外媒誉为“Sora之后最受期待的大模型之一”,真实使用效果究竟如何?Sora引发新一轮AI视频生成浪潮,国内大厂中为什么频频出圈的是阿里?“头号AI玩家”进行了一番探究。

让四郎开口唱上春山,阿里EMO模型上线通义App

一张图片就能生成唱歌视频了!

想听玛丽莲梦露唱《科目三》?安排!

想让《甄嬛传》的四郎开口唱“嬛嬛朕想睡中间”?安排!

以上两段视频,都是在通义App中用一张图片自动生成的。

4月25日,EMO模型正式上线通义App,EMO是Emote Portrait Alive的缩写,作为一款音频驱动的肖像视频生成框架,EMO可以根据输入视频的长度生成任意持续时间的视频。今年2月,阿里巴巴发布了这款全新的生成式AI模型EMO并公布了技术论文(链接已同步至文末)。

论文信息显示,在EMO之前的肖像说话(Talking Head)技术需针对人脸或身体部分做3D建模,通义实验室率先提出了弱控制设计,无需建模就可驱动肖像开口说话,大大降低了视频制作成本;

此外,EMO还学习并编码了人类表达情绪的能力,可以匹配音频内容和人物的表情、嘴型,还能将音频语气特征和情绪色彩呈现到人物微表情上。

通义实验室给出了诸多视频案例,比如,重温张国荣开口唱歌的魅力;为高启强配上罗翔老师的讲法律的语音,演一出遵纪守法的小课堂。

目前,通义App上线了80多个EMO模板,包括“啊哈哈”李玉玲语音、“钵钵鸡”等网络热梗语音素材,还有《上春山》《野狼disco》等热门歌曲。

打开通义App,进入“全民舞台”频道,选择相应音频模板,上传人物大头照,就可以制作出打破次元壁的视频。

有网友打开脑洞,让兵马俑穿越到现代,唱起《科目三》;还有网友让蒙娜丽莎和玛丽莲梦露开口说起中文;甚至让灭霸唱起《野狼Disco》。

据头号AI玩家观察,语音模板时长集中在10秒到20秒之间,EMO刚上线时需排队数小时,目前一条视频的制作等待时间在十分钟到二十分钟左右。

玩家实测制作了十余条视频发现,通义App生成的AI视频人物的不仅嘴型和声音贴合自然,连眨眼细节也处理得不错,表情生动栩栩如生,堪称毫无违和感。

但若反复观看,仍能看出AI的痕迹,人物的情绪与台词贴合不够紧密,比如马斯克笑着唱“不想上班”,山姆奥特曼略带凶狠地喊“你算是踢到棉花啦”。

虽然EMO对人类情绪的学习捕捉能力仍有进步空间,但当下的AI视频已经达到以假乱真的程度,存在被滥用的风险。

据澎湃新闻报道,为防止对口型技术被滥用,通义实验室团队在应用内预置了经过审核的音频模板,暂不开放用户在EMO中自定义音频功能和API(应用程序编程接口);此外,平台会对用户生成内容进行算法和人工两道审核,确保内容安全。

大厂逐鹿AI视频生成赛道,为什么阿里能屡屡破圈?

无论是让照片跳舞的“全民舞王”,还是让照片演戏唱歌的“全民唱演”,这些搭载在通义App(原通义千问App)上的AI视频热门玩法,都是基于阿里巴巴通义实验室在人物视频生成模型上的研究成果。

阿里巴巴通义实验室XR团队负责人薄列峰曾在2024中国生成式AI大会上透露,人物视频生成模型是其团队研究的重点,基于人物动作、人物换装、人物替身、人物唱演4个框架的应用正逐步落地通义App。

“全名舞王”背后的技术是人物动作视频生成框架Animate Anyone,该框架能够根据单张图和动作序列,输出可控的人物动作视频。而“全民唱演”则基于人物唱演视频生成框架Emote Portrait Alive,它能够根据单张图和音频,输出准确的人物唱演视频。

目前,“全民舞王”和“全民唱演”都已整合在通义App频道菜单栏的“全民舞台”入口中。

据头号AI玩家不完全统计,自去年11月份以来,国内大厂加大了在AI视频生成领域的研发投入。其中,字节跳动的动作最为频繁。无论是高层人事调整还是模型研发,都显露出字节积极布局AI视频生成领域的决心。

然而,在引爆C端话题上,阿里却始终更胜一筹。

一键让照片跳舞的“全民舞王”是基于视频生成模型Animate Anyone打造的。去年12月,该项目对外只发布了研究论文和演示。同一时期,字节跳动也发布了一个主打TikTok热舞的图生视频模型Magic Animate,还率先上线开源模型社区HuggingFace方便用户在线体验。

不过,由于使用步骤繁琐且生成等待时间较长,Magic Animate并没有在AI圈之外的C端用户群体中引起较大波澜。

相比之下,与EMO模型一样,Animate Anyone也迅速在2个月不到的时间里从模型正式落地应用端。由于使用门槛足够低,内置舞蹈模版足够丰富——涵盖科目三、鬼步舞和DJ慢摇等12种热门舞蹈,吸引了不少网友下载试玩。

最终凭借某西安网友整活的兵马俑跳“科目三”冲上微博热搜,背后的阿里通义App也随之一举破圈。

颇有意思的是,字节跳动的MagicAnimate和阿里的Animate Anyone,双方项目论文发布时间仅相差一天。

彼时,有网友戏称这是“淘宝买家秀”与“抖音舞蹈秀”之间的对决。

但恐怕所有人都没预料到的剧情是,原本在抖音上走红的魔性舞蹈“科目三”,阴差阳错之下成了“全民舞王”破圈的契机。

如今,国内各大平台上涌入了大量“全民舞王”生成的舞蹈视频。

顶流之一莫过于这只舞姿妖娆动人的奶牛猫。

目前,话题#会跳舞的奶牛猫#在小红书上已有9000万次浏览。

围绕萌宠跳舞,不少博主出的制作教程都获得了不错的流量。此外,一些网友不仅将跳舞的奶牛猫制作成了表情包,还通过绿幕抠像将其运用在了猫meme视频的创作中,促进了内容二次传播。

2024中国生成式AI大会上,薄列峰提出了一个关于AIGC内容的思考:很多生成的视频画质是OK的,模型可以生成这个世界上不存在的物种也很有意思,但你会长期去消费这样的内容吗?

“我觉得在做AIGC内容生成之前,不管是基础研究还是应用思考,大家都在高速迭代,每个人都有自己的思考和对这个问题的答案。”薄列峰表示。

从“全民舞王”到如今的“全民唱演”,阿里或许给出了问题的答案,让AI技术与用户建立起真正的联系,与人们的生活、娱乐和社交紧密联系在一起,才是AIGC内容发展的长远之道。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com