拿掉BEV之后,华为靠更好用的实时扫图功能,已经让ADS 3.0无限接近于L3级智能驾驶。而华为的ADS 3.0距离上车最短应该也就半个月的时间了,首搭车型的享界S9预计会在8月上旬就上市,相比于车型硬件的产品实力来说,华为ADS 3.0这套智能驾驶功能,也额外的抢眼。

因为这套系统上车了之后,能和它比的,应该只有特斯拉的FSD智能驾驶系统了。

目前曝光出的内测信息,大概是这套系统搭载之后,是可以在上车后直接开启智能驾驶功能,整体的功能框架是可以实现从车位到车位这种操作的。同时,优化了规控以及行车连贯性,还有更好的智能泊车功能。

现阶段,包括华为、理想,这些已经更新了智能驾驶系统之后的品牌,还是出于“全国都能开”的节点,也就是甩开了高精地图开始做无图的智驾方案。但,背后的网络还是多网合一的复杂关系。而华为ADS 3.0(应该是已经实现了)以及理想AD MAX后期的发展路线,都是做一网解决所有功能。

优化了BEV,哪里更好了?

华为对ADS 3.0系统的预热,已经有一段时间了,基本是和首搭的享界S9同步。放在旗舰车型上,又做了版本上的大迭代,虽然目前还没发布这套智驾系统具体的更新点,但,我们也可以通过华为公布的迭代路径,大概看出来ADS 3.0的更新在哪。

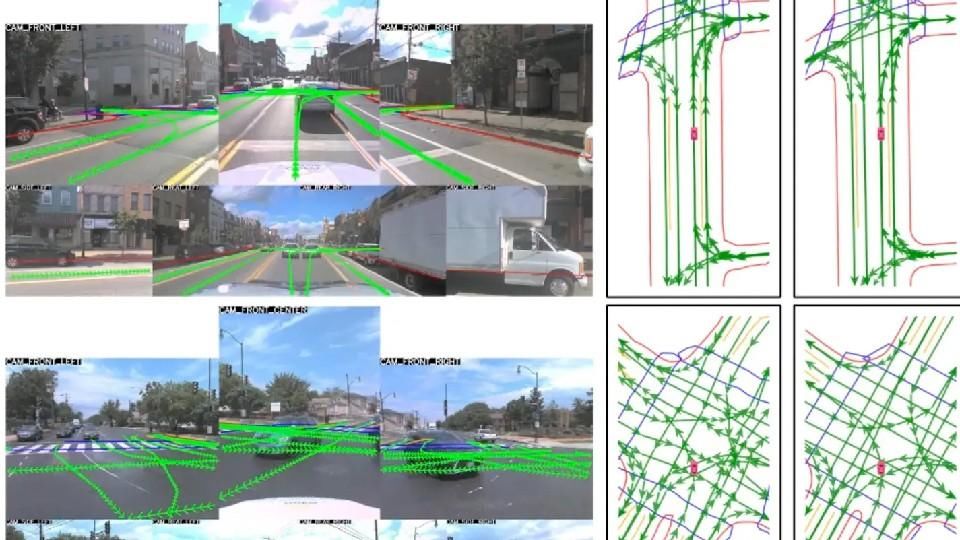

ADS 1.0到2.0,除了保留BEV之外,加了一个GOD网络,主要做异性障碍物感知的;ADS 2.0到3.0的版本迭代之后,华为ADS系统中去掉了BEV,变成了一个叫GOD的大网,所负责的模块,是目标障碍物、道路结构以及场景理解。这就和特斯拉FSD的底层逻辑,非常相似了,都是一个大网来做感知、规控以及决策等功能。

去掉BEV的价值,是什么?

在有BEV网络的时候,是因为我们需要一个BEV视角来进行对现实世界的规划,理解现实现实世界的时空关系,也是因为那时候没办法完好地理解多传感器下的时空关系构建。所以,就必须在BEV系统下进行理解。就是在一次扫描后,要确定跟踪多个目标的运动轨迹,然后传感器不断刷新,系统再不断理解。

这种传统方法,是需要将整个场景对齐(复杂路口这种就是对算力的考验了)到每个运动体的坐标系,然后还要对每个运动物体单独去做轨迹预测,所以计算成本更高了,这就是我们现在接触到的动态BEV系统。所以有的车有的智驾,在路口要求人类驾驶员接管,或者直接降级智能驾驶,就是路况太复杂BEV算不过来了。

而去掉BEV,只有GOD大网之后。单次前向传播,就可以同时生成所有运动体的轨迹,并且最后只会关注运动轨迹终点附近的区域;简单说,就是动态BEV(概念)不用始终保持注意力放在运动的物体上,而是注意它的轨迹终点附近。

在去掉BEV的前提下,通过GOD大网让ADS 3.0增强了对复杂环境及场景的全面理解和处理能力,尤其在红绿灯识别及车流信息处理等工况下。

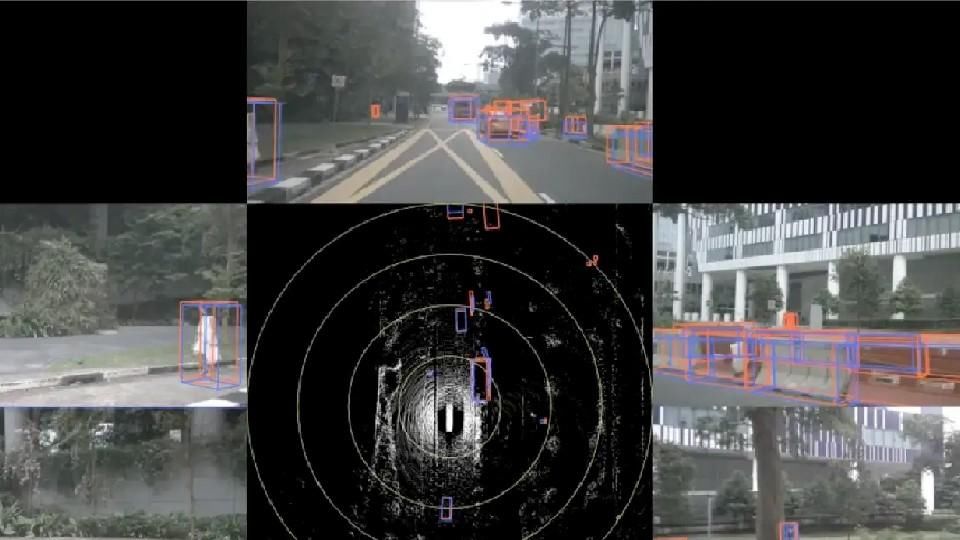

然后,提高识别度也是一个改变。当然这是站在同样水平的感知硬件基础下的,拿192线激光雷达、摄像头以及4D毫米波雷达(精度提高到5cm)这套感知硬件来做的话。GOD大网可以直接拿传感器原始数据构建模型,少了一道数据转换和融合的过程,也就是减少了感知信息的误差。

所以,ADS 3.0在对于小目标、远距离,检测能力在GOD大网后,实时扫图的效率提升了,随后带动的是感知精度的提升。具体提升多少还得等实车出来做测试,但,理论上来说BEV网络其实限制了目前激光雷达和4D毫米波雷达的性能发挥。小目标、细节上的感知提升的话,其实泊车端的改变是最明显的。

泊车,解锁了更多场景

从目前关于华为ADS 3.0在享界S9上的内测版本使用信息来看,它的行车状态和规控层面,做到了更类人的体验;行车连贯性,有提升,不是特别复杂的路况下,可以上车就开智能驾驶,直接到下车都不用接管(存疑)。

以上两个层面的改变是正常该有的水平。

为什么会这么说?因为GOD大网就是端到端的能力,投喂、学习、训练高频次的重复这个循环后,是可以具备类人的驾驶逻辑和体验的。同时,由于减少了BEV网络之后,所有功能都在GOD大网中来做,更连贯的驾驶是必须的,否则就失去了大网的意义。

再讲讲从起步车位到停车车位这种智能驾驶功能,怎么实现的。其实难点就是在从车位出去的这一个点,执行逻辑应该是需要通过感知设备对车位附近信息的扫描与收集(因为没有高精地图可参考),找到车场出口,其实依靠的还是实时扫图这个核心功能。

功能逻辑上是通用的,用实时扫图,ADS 3.0可以持续优化驾驶路径(无论在哪,车库、城区、高速都一样),避开拥堵或危险路线,选择更为高效的通行路线。也就是在最难理解的地库车位,也能根据“指示牌、地面标识”等信息,收集到与出口相关的信息并且规划好路径;之后在路面上就是城区NOA功能,高速上就用高速NOA功能。

起步就开智驾,这个难点,用我们消费者的角度来看,就是靠实时扫图这个功能来打通的(其实背后还有理解能力更好的算法做支撑),而后这个功能会在A点到B点这整个过程中贯穿始终来为接近L3级的智能驾驶功能做支持。

剩下的一些技术提升,体现在了更好的泊车功能上。

说白了,其实就是拼感知细节和理解能力。ADS 3.0内测的享界S9上,自动泊车功能可以判断车位上有地锁,在解锁地锁后,不用再上车,车辆识别后会自动停好。

这里的工作逻辑拆解:

- 硬件感知到车位,算法把车领到车位并且开始泊车操作;

- 在地锁前面刹停,司机下车解除地锁;

- 感知设备(模型中),没有障碍物(地锁);

- 泊车功能继续正常使用,顺利泊车。

在这个工况下,主要还是GOD大网在对感知环境理解层面的提升,让它对异性障碍物出现后也不用停止功能,而是等待障碍物(这里应该有个标注,不中断操作那种)解除后,继续执行。

还有一个工况,是停车时遇到车位在马路牙上方,ADS 2.0的时候车辆是开不上去的,但,ADS 3.0可以判断高度,且在不托底的情况下自动开上去停好。这个工况没什么难度,应该是4D毫米波雷达来实现的这个功能。

目前来看华为的ADS 3.0系统,如果能做到落地即可实现上车就开智驾,从A到B不接管,那么它的水平,就基本处于一个无限L3级的智能驾驶系统。主要是它用GOD大网,把所有功能的连贯性打通了。应该至少在今年内,华为ADS 3.0之后,没有人愿意去和这套系统做对比了,因为从系统逻辑、功能体验上,已经有代差了。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com